Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

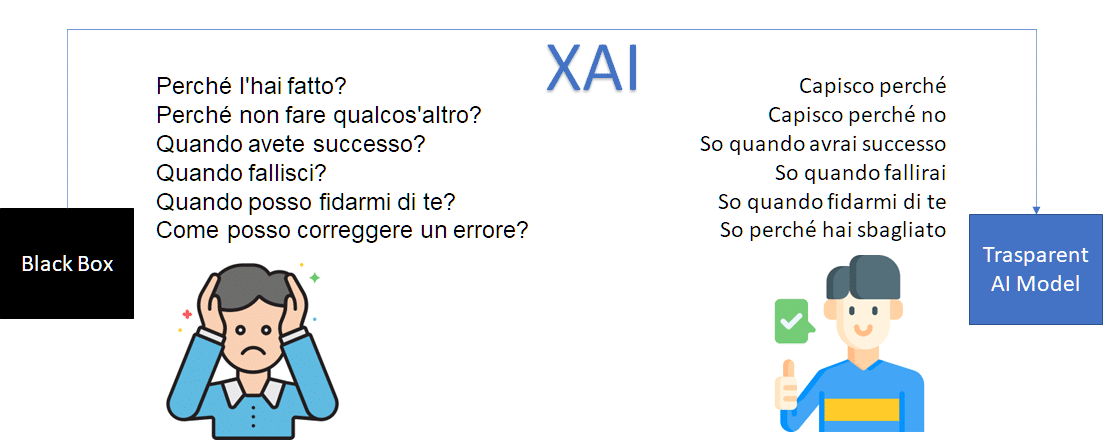

L’intelligenza artificiale (IA) sta rivoluzionando il modo in cui interagiamo con le tecnologie e prendiamo decisioni basate sui dati. Tuttavia, con l’aumento della complessità degli algoritmi di IA, si rende necessario comprendere come tali decisioni vengano prese. Ecco dove entra in gioco l’XAI, acronimo di Explainable Artificial Intelligence, che mira a rendere l’IA trasparente e comprensibile per gli esseri umani. L’XAI si concentra sulla spiegazione delle decisioni prese da un algoritmo di IA. Consente agli utenti di comprendere il “perché” di una determinata scelta e di fidarsi delle soluzioni proposte. In questo articolo, esploreremo nove framework di XAI che offrono strumenti e tecniche per comprendere, interpretare e spiegare il funzionamento dei modelli di IA

LIME è una tecnica di spiegazione locale, agnostica al modello, utilizzata per interpretare modelli “black-box” apprendendo un modello locale attorno alle previsioni. Questo framework fornisce una comprensione globale intuitiva del modello, rendendolo utile anche per gli utenti non esperti. L’algoritmo è stato proposto per la prima volta nel paper di ricerca “Why Should I Trust You?” Explaining the Predictions of Any Classifier. LIME svolge un ottimo lavoro nell’interpretare qualsiasi classificatore o regressore in modo fedele, utilizzando modelli locali interpretabili approssimati. Questo framework fornisce una prospettiva globale per stabilire fiducia in qualsiasi modello “black-box”. Consente di identificare modelli interpretabili basati su una rappresentazione comprensibile per l’uomo, fedele localmente all’algoritmo. Quindi, LIME si basa principalmente sull’apprendimento di rappresentazioni di dati interpretabili, mantenendo un equilibrio tra fedeltà e interpretabilità e cercando esplorazioni locali.

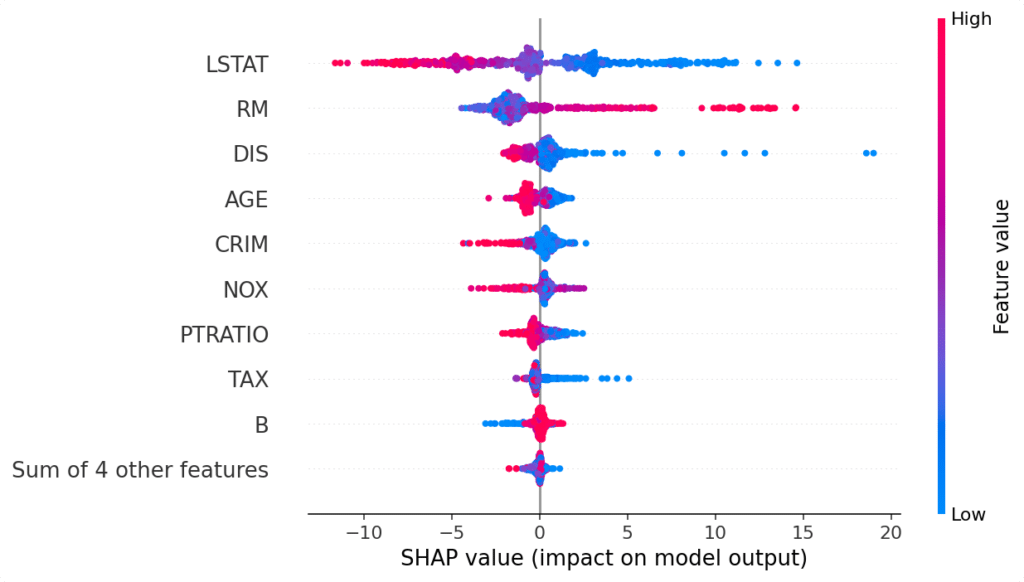

Il framework XAI SHapley Additive exPlanation (SHAP) è stato introdotto nel 2017 da Lundberg e Lee nel paper “A Unified Approach of Interpreting Model Predictions“. Questo framework si basa sul concetto di valori di Shapley della teoria dei giochi cooperativi. L’algoritmo SHAP considera l’importanza additiva delle caratteristiche per spiegare il contributo collettivo delle diverse caratteristiche del modello sottostante. Matematicamente, il valore di Shapley è definito come la media del contributo marginale individuale dei valori delle caratteristiche su tutti i possibili intervalli di valori nello spazio delle caratteristiche.

Testing with Concept Activation Vector (TCAV) è un framework di interpretazione di modelli di intelligenza artificiale sviluppato da Google AI. Utilizza Concept Activation Vectors (CAV) per interpretare l’attivazione delle unità interne del modello in relazione a concetti comprensibili per gli utenti. TCAV valuta l’importanza di questi concetti utilizzando derivate direzionali per le previsioni del modello. È un approccio innovativo per comprendere come i modelli interpretano e utilizzano i concetti durante le loro previsioni, fornendo spiegazioni comprensibili e interpretabili.

Diverse Counterfactual Explanations (DiCE) è un framework di interpretazione dei modelli di intelligenza artificiale che si concentra sull’offrire spiegazioni basate su contromisure diverse. Questo framework è stato sviluppato per fornire una comprensione più approfondita del motivo per cui un modello di machine learning prende una determinata decisione. L’obiettivo principale di DiCE è quello di generare diverse contromisure che possono essere prese in considerazione per cambiare l’output del modello. In pratica, DiCE crea diverse istanze di input “contromisura” che potrebbero portare a un diverso risultato da quello originale del modello. Queste contromisure possono aiutare a identificare e comprendere i fattori chiave che influenzano le decisioni del modello. Il framework DiCE è particolarmente utile in situazioni in cui è necessario comprendere come il modello risponde a determinati cambiamenti o intervenire sulle sue decisioni. Fornisce una prospettiva diversificata su come le variazioni negli input possono influire sulle predizioni del modello. DiCE è un potente strumento per interpretare i modelli di intelligenza artificiale, fornendo spiegazioni basate su contromisure diverse che consentono una migliore comprensione delle decisioni del modello.

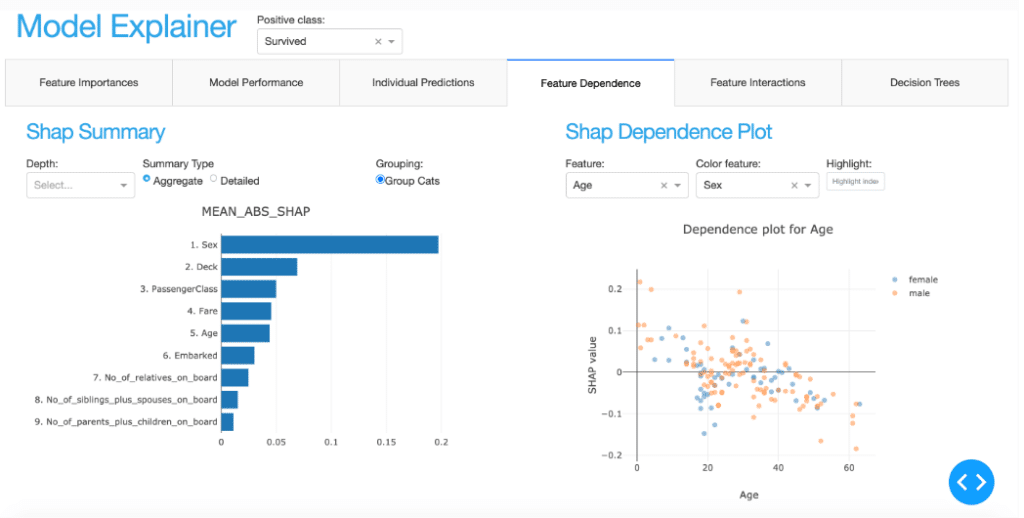

Explainerdashboard è un framework XAI di interpretazione dei modelli di intelligenza artificiale che mira a fornire spiegazioni chiare e intuitive sulle decisioni dei modelli. Con un focus sull’interattività e l’accessibilità, questo framework consente agli utenti, anche non esperti, di comprendere facilmente le ragioni alla base delle previsioni del modello. L’obiettivo principale di Explainerdashboard è quello di presentare le spiegazioni in un formato visivo e interattivo, utilizzando grafici, tabelle e altri elementi visivi. Questo rende più semplice comprendere le relazioni tra le variabili di input e le previsioni del modello. Grazie all’utilizzo di Explainerdashboard, gli utenti possono analizzare e interpretare i modelli di intelligenza artificiale in modo più approfondito. I diversi strumenti offerti da questo framework consentono di esplorare le variabili di input più importanti per le previsioni del modello, confrontare le previsioni effettive con quelle del modello e visualizzare i valori di input e output in modo chiaro e comprensibile. In conclusione, Explainerdashboard è un framework innovativo che fornisce spiegazioni comprensibili e interpretabili sulle decisioni dei modelli di intelligenza artificiale. Con la sua interfaccia visiva e interattiva, offre agli utenti un modo intuitivo per comprendere come i modelli interpretano e utilizzano le informazioni durante le loro previsioni.

DALEX (moDel Agnostic Language for Exploration and eXplanation) è uno dei pochi framework XAI ampiamente utilizzati che cerca di affrontare la maggior parte delle dimensioni dell’interpretabilità. DALEX è agnostico al modello e può fornire alcune informazioni sul dataset sottostante per dare contesto alla spiegazione. Questo framework fornisce approfondimenti sulle prestazioni del modello e sull’equità del modello, oltre a offrire spiegazioni globali e locali del modello. Gli sviluppatori del framework DALEX hanno voluto soddisfare i seguenti requisiti, che hanno definito al fine di spiegare algoritmi complessi “black-box”:

Giustificazioni delle previsioni: secondo gli sviluppatori di DALEX, gli utenti del modello di ML dovrebbero essere in grado di capire le attribuzioni delle variabili o delle caratteristiche della previsione finale.

Speculazioni sulle previsioni: formulare ipotesi su scenari di “what-if” o comprendere la sensibilità di particolari caratteristiche di un dataset nei confronti dell’output del modello sono altri fattori considerati dagli sviluppatori di DALEX.

Convalida delle previsioni: per ogni risultato previsto da un modello, gli utenti dovrebbero essere in grado di verificare la forza delle evidenze che confermano una particolare previsione del modello.

ALIBI è un framework di explainability per modelli di intelligenza artificiale. È model-agnostic e offre diverse tecniche di spiegazione, inclusa l’importanza delle variabili e le spiegazioni locali. ALIBI permette di comprendere le decisioni dei modelli e offre funzionalità avanzate come la verifica delle previsioni. È uno strumento potente per interpretare e spiegare i modelli di machine learning.

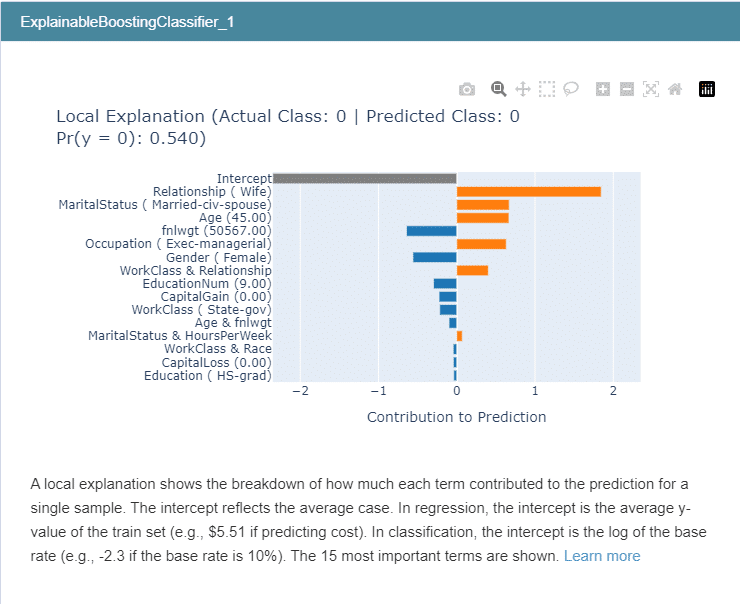

InterpretML è un framework XAI sviluppato da Microsoft. Il suo obiettivo è fornire una comprensione approfondita dei modelli di machine learning per il debugging dei modelli, la spiegazione dei risultati e le verifiche regolatorie dei modelli di machine learning. Con questo modulo Python, è possibile addestrare modelli trasparenti interpretabili o spiegare modelli “black-box”.

Microsoft Research ha sviluppato un altro algoritmo chiamato Explainable Boosting Machine (EBM), che combina tecniche moderne di machine learning come boosting, bagging e rilevamento automatico delle interazioni con algoritmi classici come Generalized Additive Models (GAMs). Gli studi dimostrano che le EBM sono accurate quanto random forest e gradient-boosted trees, ma a differenza di tali modelli “black-box”, le EBM sono esplicative e trasparenti. Pertanto, le EBM sono modelli “glass-box” integrati nel framework InterpretML.

Explain Like I’m Five (ELI5) è un framework di explainability progettato per spiegare in modo semplice e comprensibile i modelli di intelligenza artificiale. L’obiettivo principale di ELI5 è rendere l’interpretabilità dei modelli di machine learning accessibile anche ai non esperti. ELI5 utilizza diverse tecniche per spiegare i modelli, tra cui l’importanza delle variabili, l’analisi delle feature e l’interpretazione delle previsioni. Questo framework offre spiegazioni chiare e concise, utilizzando un linguaggio adatto ai bambini, per aiutare le persone a comprendere come funzionano i modelli di intelligenza artificiale. Inoltre, ELI5 supporta diversi tipi di modelli, sia quelli “black-box” che quelli interpretabili, consentendo di spiegare una vasta gamma di algoritmi di machine learning. Questo framework è implementato come una libreria Python e può essere facilmente integrato nei progetti di machine learning. In sintesi, Explain Like I’m Five (ELI5) è un framework di explainability che semplifica l’interpretazione dei modelli di intelligenza artificiale attraverso spiegazioni comprensibili e accessibili a tutti, anche ai non esperti.

Per vedere dei tutorial di Explainable Artificial Intelligence cerca nella sezione XAI del nostro sito.