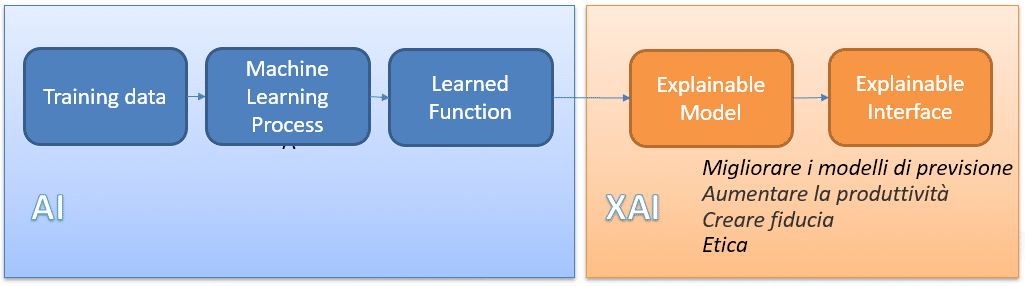

In questo articolo classificheremo le tecniche di Explainable Artificial Intelligence (XAI) cioè quelle tecniche che permettono di trattare i modelli di previsione con maggiore trasparenza. Il crescente uso di tecniche deep Learning nella nostra vita quotidiana, pone l’attenzione sull’interpretabilità e spiegabilità dei modelli usati.

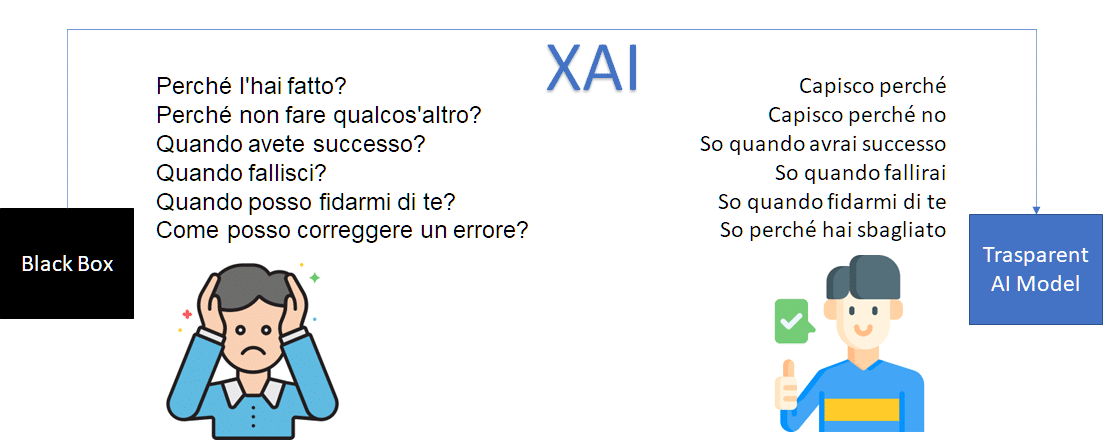

Nel campo della ricerca, molti obiettivi sono stati raggiunti in ambito dell ‘EXplainable Artificial Intelligence (XAI). Per XAI si intendono quell’insieme di metodi e processi che consentono agli utenti di comprendere i risultati dei modelli deep learning e quindi migliorarli o studiare i potenziali errori.

Perché l’Explainable Artificial Intelligence è cosi importante nel deep learning?

L’Explainable Artificial Intelligence (XAI) è molto importante in quanto aiuta a migliorare diversi aspetti di un modello deep learning:

- Correttezza (Fairness): Le tecniche XAI permettono di capire perché un modello AI ha dato come risultato un determinato output. Supponiamo per esempio che un’azienda usi un algoritmo AI per decidere se concedere una promozione o no ad un dipendente, Le tecniche XAI ci aiutano a capire quali sono i fattori che ad alcuni dipendenti è stato concesso e ad altri no.

- Affidabilità (Reliability):Le tecniche XAI permettono di valutare i modelli AI di essere affidabili e quindi non permettere che piccoli cambiamenti nell’input alterino drasticamente l’output.

- Casualità (Casuality): Tramite le tecniche XAI è possibile capire se il processo decisionale del modello AI sia influenzato da relazioni causali.

- Fiducia (Trust): Le interpretazioni fornite dalle tecniche XAI rende “umano” il modello AI e quindi aumenteranno la fiducia nell’usare i risultati nella società.

Metodi XAI: Classificazione delle tecniche per tipologia di visibilità

L’interpretabilità implica la comprensione di un modello, questa comprensione può essere classificata a seconda della tipologia di visibilità che vogliamo ottenere. I metodi XAI si possono classificare in:

- Metodi di interpretabilità globale: in questo caso si interpreta la logica intera del modello. Quindi i risultati ottenuti dall’interpretazione sono legati a tutti gli output possibili della previsione. Questi metodi sono molto utili su modelli Machine learning per previsioni a livello di popolazione, come per esempio andamento dei consumi o cambiamento climatico.

- Metodi di interpretabilità locale: in questo caso i risultati ottenuti riguardano una singola previsione. Queste tipologie di metodi XAI sono utili su modelli machine learning a livello di individuo come per esempio quando si affida la promozione del personale ad un modello machine learning oppure un altro esempio a livello industriale nei modelli Ai di manutenzione predittiva dove attraverso i metodi XAI è possibile interpretare la previsione di guasto e fornire al team di manutenzione informazioni su come intervenire per evitare lo stop dell’impianto. A volte tecniche di interpretabilità locale vengono usate globalmente considerando l’intero insieme di osservazione.

Metodi XAI: tecniche correlate al modello

Un altro modo di classificare le tecniche di Explainable Artificial Intelligence è in agnostiche rispetto al modello, nel senso che possono essere applicate a qualsiasi algoritmo machine learning o specifiche ovvero tecniche applicabili ad una singola tipologia o classe di algoritmi machine learning. Quindi:

- Model Specific: limitate a classi di modelli specifici, per questo svantaggio di recente si è assistito a un aumento dell’interesse alle model-agnostic.

- Model-Agnostic: non vincolate al modello di machine learning usato.

Metodi Model-Agnostic

I metodi XAI model-agnostic si dividono in quattro tipologie differenti:

- Visualizzazione: hanno lo scopo di esplorare in pattern presenti all’interno dei neuroni. Tra le tecniche di visualizzazione abbiamo: Partial Dependence Plot, i metodi surrogati e gli Individual conditional expectaction (ICE).

- Knowledge extraction: il compito di queste tecniche è quello di estrarre le conoscenze acquisite da una rete neurale durante il training. Le più comuni sono le rule extraction e le model distillation.

- Metodi di influenza: Stimano l’importanza delle variabili di input e quindi il loro comportamento nel modello. Sostanzialmente variando l’input si stimano quanto le variazioni effettuate influenzano il modello. Le tecniche più comuni sono la sensitivity analysis, la feature importance e la layer-wise relevance propagation.

- Example-based explanation: queste tecniche utilizzano particolari istanze dell’insieme di input per spiegare il comportamento dei modelli. Due tecniche utilizzate sono le spiegazioni controfattuali e la contro interpretazione.

Di seguito riportiamo una tabella delle tecniche più comuni e la loro tipologia. Indichiamo con L: Locale, G: Globale per indicare il tipo di visibilità mentre AG sta per agnostico e SP per specific.

| Tecnica | Visibilità | AG/SP |

| Decision trees | G | SP |

| Rule lists | G | SP |

| LIME | L | AG |

| Shapely explanations (SHAP) | L | AG |

| Saliency map | L | AG |

| Activaction maximization | G | AG |

| Surrogate models | G/L | AG |

| Partial dependence plot (PDP) | G/L | AG |

| Individual conditional Expectation (ACI) | L | AG |

| Rule extraction | G/L | AG |

| Decomposition | L | AG |

| Model distillation | G | AG |

| Sensitive analysis | G/L | AG |

| Layer-wise Relevance propagation (LRP) | G/L | AG |

| Feature importance | G/L | AG |

| Prototype and criticism | G/L | AG |

| Conterfactuals explanations | L | AG |

Se vuoi rimanere aggiornato sulle tecniche di Explainable Artificial Intelligence segui la sezione XAI del nostro blog.